- HOME

- AIは「理解するもの」ではなく「捉えるもの」

生産現場 予知保全・品質改善

AIは「理解するもの」ではなく「捉えるもの」

製造業のデータ活用において注目されているAIの実用化。

今回は、AIの検討が進み、実際の検証や実運用へ適用する際に発生する「AIが判断した理由が分からない」という問題を取り上げます。

この問題に対して今日では実業務への適用に向けて様々な手法の研究や開発が進んでいます。この問題にどう取り組むのか、技術動向と共にTEDの提案をご紹介します。

目次

製造業のデータ活用においても注目されているAI、昨今では様々な領域で導入が進められています。一方で、「AIは分かりにくい」というイメージをお持ちではないでしょうか。

AIで用いられる機械学習の技術は、十分な量のデータがあり、判断の「結果」を重要視する課題を得意としています。例えば、囲碁将棋の勝ち負けのように結果がよければ、つまりモデルの精度が高ければ、理由や根拠がなくてもよいケースもあります。

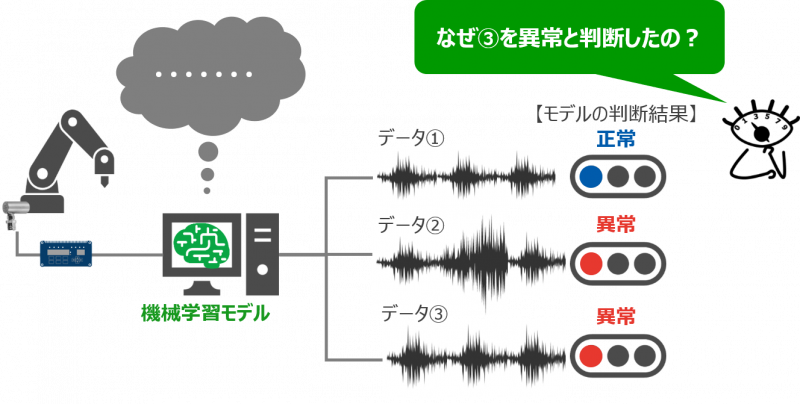

しかし、このようなケースばかりではありません。実際のビジネス現場においては、AIの判断理由を知りたい要望があることがほとんどです。TEDでもAIを検討されているお客様から「AIが判断した根拠は分かるの?」という質問をいただくことがあります。

モデルを作成する段階においては、学習データが適切だったか、データのどこを判断したのかを検証したい要求があります。また、モデルの実用化に向けては、作成モデルにどの程度信頼性があるのかを他部署や社内外の関係者に意思決定の根拠として示す必要も出てきます。

製造業での予知保全の例で考えてみましょう。設備の異常を判断した根拠が分からない状態で、その判断を信頼して即時に製造ラインを止めることが可能でしょうか。そこまでの決定権をAIに与えるのは難しいと直感的に考える人が多いのではないでしょうか。

現実の問題として、意思決定に人が関わっている限り、必ずその判断理由を求められる場面があります。モデルの精度は重要な評価指標の一つですが、AIの導入以前に培ってきた業務知識を持つ人の「納得感」が最終的に必要になるのです。

そもそも、なぜ「AIは分かりにくい」と言われるのでしょう。厳密には「人の直感からかけ離れた規模の条件があり、複雑すぎて人が分かるように口頭で説明できない」というのが正確です。

AIの機械学習アルゴリズムの複雑さと分かりやすさは、トレードオフの関係にあります。一方で、データ形式や適応する領域にもよるものの、一般的にアルゴリズムが複雑になるほど複雑な事象や課題を解くことができ、モデルの精度も高まる傾向にあります。その結果、より高い精度を求めるとAIが判断した理由がより分かりにくくなり、モデルをどの程度信頼してよいのか人が判断できないジレンマが発生します。

このため「AIが考えたことが全て分かるか?」という問いに対しては、残念ながら厳密には「分からない」というのが答えです。それでは、判断の根拠が重要視されない領域にのみAIを導入する、もしくは人はAIの高い精度を信じて導入を進めるしか無いのでしょうか?AIの実用化が進むに伴い、近年では「分かりにくいAI」をより「説明可能なAI」に近づける技術開発が進められています。このような技術の総称をXAI(eXplainable AI)と呼びます。

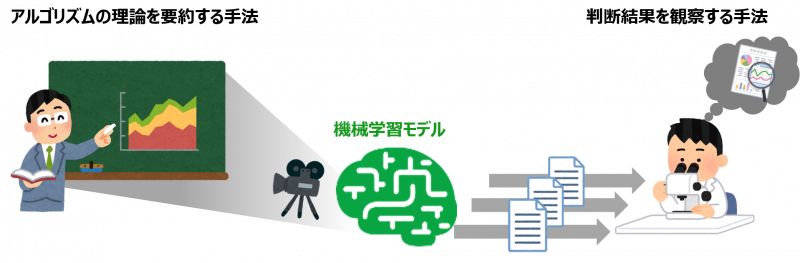

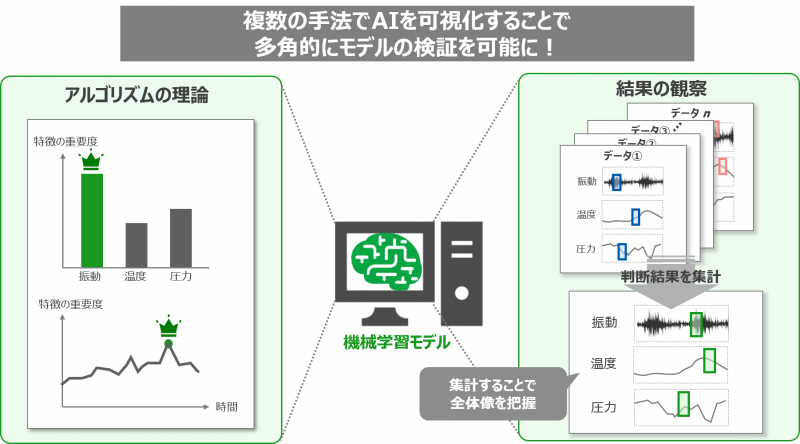

XAIでは、どのように説明可能なAIを実現しようとしているかを見てみましょう。大きくは2つのアプローチがあります。1つ目は、AIの内部の仕組みを人が分かるようにアルゴリズムの理論を要約する方法、2つ目は、AIがデータを判断した結果を観察して説明する方法です。言うなれば「分かりにくいAI」の全てを理解しようとするのではなく、様々な面から概要を「捉える」アプローチです。

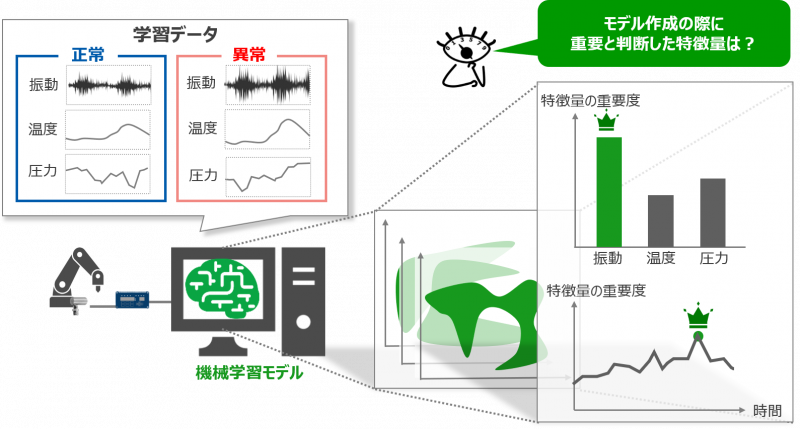

1つ目の方法としては、データを学習してモデルを作成した際に、どの部分の特徴を重要視しているかを可視化する手法(Feature Importance)があります。データ分析においては従来からよく使用されている手法で、モデル内部の仕組みを要約できるため、モデルの全体像を把握することに適しています。

■アルゴリズムの理論を要約する手法(Feature Importance)

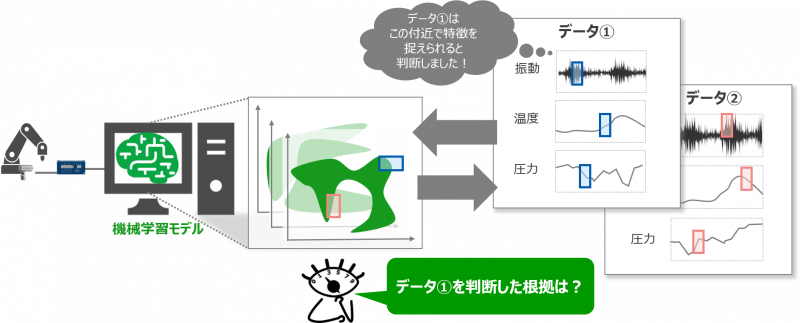

2つ目の方法の代表的な例としては、学習データとそれに近いデータを多数作成して作成モデルで判断し、その結果をもとにデータのどの部分を特徴として捉えたかを可視化する手法(LIME)があります。この手法は、一つ一つのデータの判断根拠を把握することに適しています。

■判断結果を観察する手法(LIME)

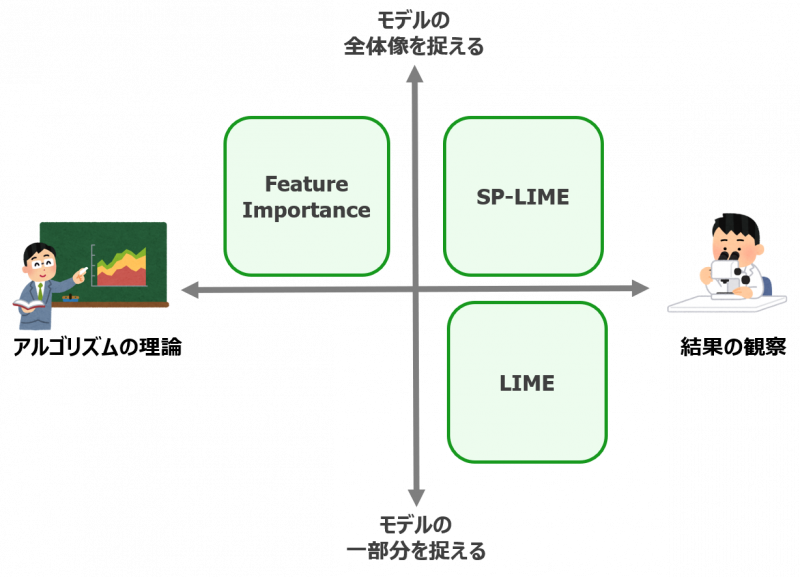

これらの手法には、それぞれ得意な点と弱点があります。1つ目のFeature Importanceの手法では、モデル全体を把握することはできますが、各々のデータの判断結果がどのような傾向になるか分かりません。また、モデル内部を理論的に捉えるため、使用するアルゴリズムが変わると算出できなかったり、算出方法が変わります。つまり、アルゴリズムに依存する手法になります。

逆に2つ目のLIMEの手法では、各々のデータの判断結果を説明できますが、モデルのある一部分しか捉えられておらずモデル全体の傾向は分かりません。こうした弱点を補うべく、各々のデータの判断結果の集計によってモデル全体像の把握につなげる手法(SP-LIME)が近年では開発されています。

また、説明できる内容以外にも、ランダム性のある理論をもとにしているかという視点の「説明結果の安定性」、どの程度の処理速度が必要かという視点の「計算コスト」といったポイントがあり、まとめると以下のようになります。

これまで挙げたもの以外にも、現在では様々な手法があります。どの手法がよいかは、データの特性や業務背景、要求される説明内容により選択が必要なのが現状です。

例えば、前述のLIMEに近い局所的な説明の手法でSHAPという手法があります。様々な領域で用いられている手法ですが、センシングデータのような時系列データにおいては、データの時間による変遷も特徴として捉えなければならないので、捉えるべき対象の数が非常に多くなってしまい、その差を効果的に検出することが難しくなる…といったデータ特性との親和性に課題が発生するケースもあります。

TEDでは、これらの手法の特性と実際の業務背景の多様性を踏まえ、複数の視点からデータ特性に合った手法で多角的にモデルを捉えることが重要と考えています。

なぜ複数の視点が必要なのでしょうか?その理由は、複数の視点を持つことでよりモデルの信頼性が高まるためです。複数の検証結果が、同一の傾向を示すことで根拠の説得力が増すことは、想像に難くありません。しかし、検証結果が一致しない場合においても、どこが異なっているのかを業務知識と併せて読み解くことで、より深くモデルの検証を行うことができます。

例えば、実業務と照らし合わせてデータの判断結果や根拠は合っているが、特徴量の重要度とは合っていないような場合には、モデル作成時の学習データに何かしらの不備がある(ノイズデータが混じっている、データ量が不足している等)と解釈することができます。

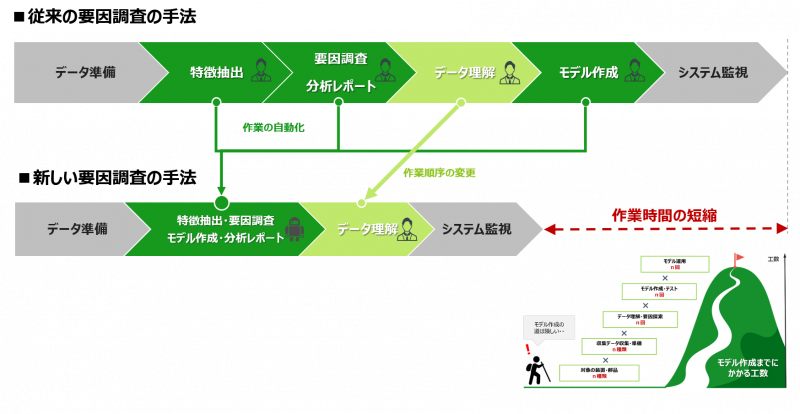

これまでご紹介した「説明可能なAI」の用途は、人がモデルの判断根拠を検証するためのものでしたが、実はもう一つ「要因調査」という重要な利用方法があります。

いわば、AIができる説明そのものを業務課題の解決に使ってしまおうという逆転の発想です。AIが得意とする複雑な条件が絡み合ってブラックボックス化しているような課題を、AIに説明させることで要因がどこにあるかを確認することが可能になるのです。

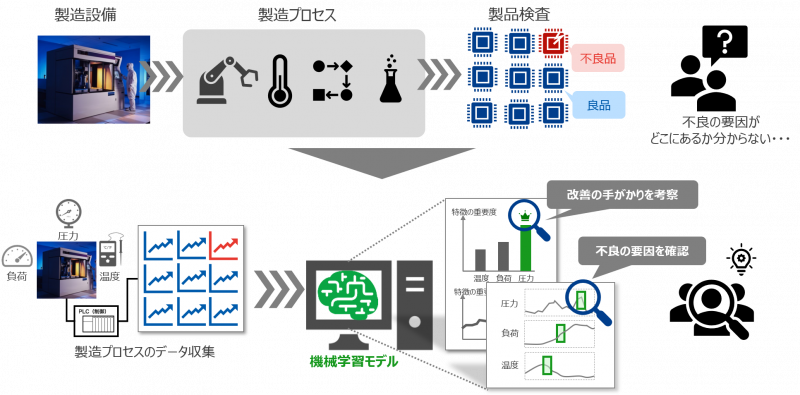

例えば、ある製造設備で、製品検査時に不良品の発生は検出できるが、製造プロセスのどのような設備状態や設定が要因で不良品の製造に繋がっているか分からない…というような課題が考えられます。この課題に対して、製造プロセスで取得した設備のデータと製造後の良/不良の結果のデータを元に、AIによるデータ分析を行います。そして、AIが不良品と判断したデータについて、どの部分を根拠として判断したのかを示すことで、不良の要因を確認することができます。また、併せてAIモデル全体の特徴を捉えることで、製造プロセスの運用改善の考察に繋げることも可能となります。

今回ご紹介したような手法を利用することで、「AIは分かりにくい」という問題に対して、AIのすべてを理解しようとするのではなく、様々な側面や要約した情報から多角的に「捉えること」ができるとTEDは考えています。そして、それが速やかなAI実用化へと繋がり、更には要因調査という新たな課題解決方法へと発展させることができると考えます。

今後弊社製品CX-Mにも、従来よりもこれらの手法を強化した新しい「要因調査モデル」の機能を搭載する予定です。乞うご期待ください。